Lo importante es entender que no es su fallo, es el nuestro. La herramienta es la que es, tenemos que aprender a utilizarla.

De todas maneras, en los últimos meses los LLMs han progresado mucho y para la mayoría de las tareas sencillas llega con dirigirnos a ellos en lenguaje natural. Pero es cierto que tienen ciertas limitaciones que tenemos que conocer si les queremos sacar el máximo partido.

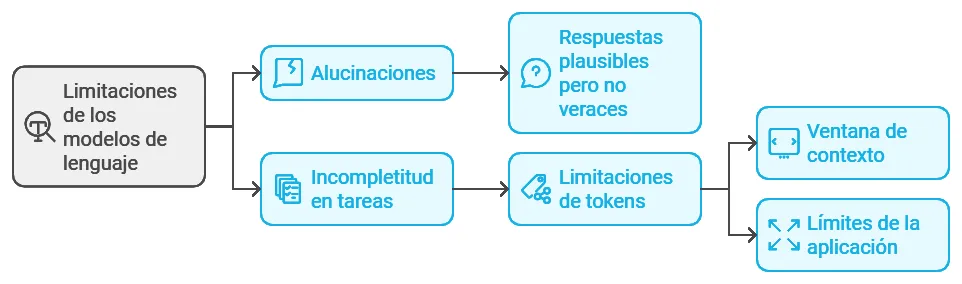

Limitaciones de los modelos de lenguaje

Las inteligencias artificiales nos mienten

Efectivamente, por como han sido entrenadas, los LLMs nos dan respuestas plausibles, no veraces por eso existe la posibilidad de que se produzcan lo que se conocen como alucinaciones, en las que la inteligencia artificial nos da una respuesta errónea pero que parece cierta. Los modelos de lenguaje han sido entrenados con cantidades enormes de datos, entienden el contexto y asignan una probabilidad a la siguiente palabra, en función de esto van creando frases posibles, probables, pero no necesariamente ciertas. Por eso es importante revisar todo el contenido generado con inteligencia artificial

Las inteligencias artificiales son unas vagas.

Otro de los problemas habituales es que no acaben una tarea, les pides diez ideas de contenido y te responde con cinco. Esto, normalmente, no es una limitación del modelo, sino de la aplicación de chat que estamos utilizando.

Las inteligencias artificiales dividen los textos en tokens, que pueden ser palabras o partes de una palabra. Por un lado, el modelo tiene sus propias limitaciones de tokens, lo que se llama la ventana de contexto. Por otro lado, la propia aplicación de chat con la que nos conectamos al modelo puede imponer límites a los tokens que usamos, ya que se cobra por tokens usados.

Estos dos factores pueden hacer parecer que la inteligencia artificial es vaga o perezosa, cuando el problema está en los Tokens.

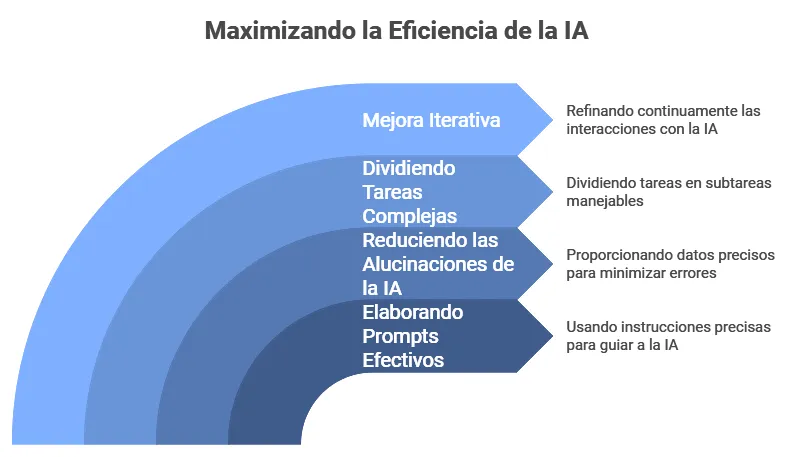

Entonces, ¿Cómo les sacamos partido?

La inteligencia artificial generativa es una herramienta muy poderosa si la usamos adecuadamente. Lamentablemente, no estamos todavía en la fase de darle una instrucción compleja y dejarla hacer la tarea mientras nos vamos a la playa.

Actualmente los LLMs son unas herramientas poderosas, pero hay que saber usarlas.

Empieza por un buen prompt

El prompt es como se conoce a las instrucciones que les demos a los LLMs y aunque en la mayoria de las veces utilizar lenguaje natural es suficiente, si quieres exprimir la IA utilizar un buen prompt es la clave. En la publicación de mañana veremos técnicas básicas de prompting así que si no estás suscrito no te olvides de hacerlo.

Aunque es imposible evitar al 100% las alucinaciones, una técnica que funciona muy bien para reducirlas es aportarle los datos que va a necesitar.

Una de las tareas en las que más partido le saco yo a la inteligencia artificial es la creación de las fichas de producto de mi tienda online. Es muy importante que las fichas de los productos sean fiables y precisas y al principio se me inventaba los datos. Al aportarle la página web del fabricante, la ficha técnica del producto y otra información relevante en el prompt hemos reducido las alucinaciones por debajo del 1% Aún así, siempre revisamos las fichas para asegurarnos de que sean correctas.

Divide las tareas complejas

Al dividir tareas complejas en subtareas evitamos el problema de la ventana de contexto y las limitaciones artificiales de tokens. La IA no está para escribir el libro por ti, pero si puede hacer que tu seas mucho más productivo.

Yo mismo, para escribir estos artículos, empiezo con una sesión de brainstorming mientras conduzco y utilizo la función de voz avanzada de ChatGPT. En estas sesiones planteo lo que quiero tratar. Una vez ya en mi ordenador, retomo el log de esas conversaciones y le pido que me haga una estructura del artículo. Sobre esa extructura lo escribo a mi manera y con mi toque personal. Luego le pido que me corrija lo ortografía y resalte con negritas los conceptos más importantes. Sobre ese borrador vamos trabajando hasta que lo considero terminado, en muchos casos pidiéndole consejo o utilizando otra IA para documentarme.

En el caso de las fichas de producto, que lo tenemos muy pulido, con un GPT personalizado, hemos pasado de una media de 30 minutos por ficha a 6 minutos por producto. En el caso de los artículos he pasado de 4 horas a 1 hora y media, y eso que estoy empezando y aún no tengo ningún GPT personalizado para este tema (un 'GPT personalizado' es una versión entrenada específicamente para adaptarse a necesidades particulares, ofreciendo respuestas más ajustadas a un contexto específico).

Itera, itera, itera

Una cosa que no podemos perder de vista con los LLMs es que el interfaz es un chat para que lo usemos. Si le pides algo a la IA y el resultado no te gusta, díselo, no se va a ofender, explícale qué es lo que ha hecho mal y qué es lo que quieres. En algunos casos tendrás que empezar de 0 con un buen prompt, o un GPT personalizado, pero en la mayoria, lenguaje natural, interacturar con el chat y algún truquito que te enseñaré mañana son más que suficientes para obtener resultados más que satisfactorios.

No olvides suscribirte si aún no lo has hecho y compartelo a quien creas que le puede interesar. En el boletín de mañana, exploraremos técnicas básicas de prompting que te ayudarán a obtener respuestas más precisas y útiles de las inteligencias artificiales. ¡No te lo pierdas!